Google vs Nvidia,一文深度拆解 TPU 與 GPU 的性能、生態與產業鏈差距

本文將系統回答一系列核心問題,從價格、性能、架構、生態到產業鏈與戰略動因,深度分析 TPU 與 GPU 的最新差距與潛在走向。

過去數月,Google 試圖將自研 AI 芯片 TPU(Tensor Processing Unit)出售或租賃給非 Google Cloud 客戶,這一動作不僅撼動行業,也引發了英偉達的密切關注。

值得注意的是,全球兩款最先進的大模型——Google Gemini 與 Anthropic Claude——均部分或完全由 TPU 訓練完成,而非英偉達 GPU。這一現實正在改變 AI 計算市場的競爭格局。

越來越多的科技巨頭也開始重新評估 TPU 的價值,其中包括英偉達的大客戶 Meta。

雖然英偉達依舊在性能與生態上佔據壓倒性優勢,但 Google 正在以更開放的策略推動 TPU 進入更多數據中心,與英偉達正面競爭的趨勢越發明顯。

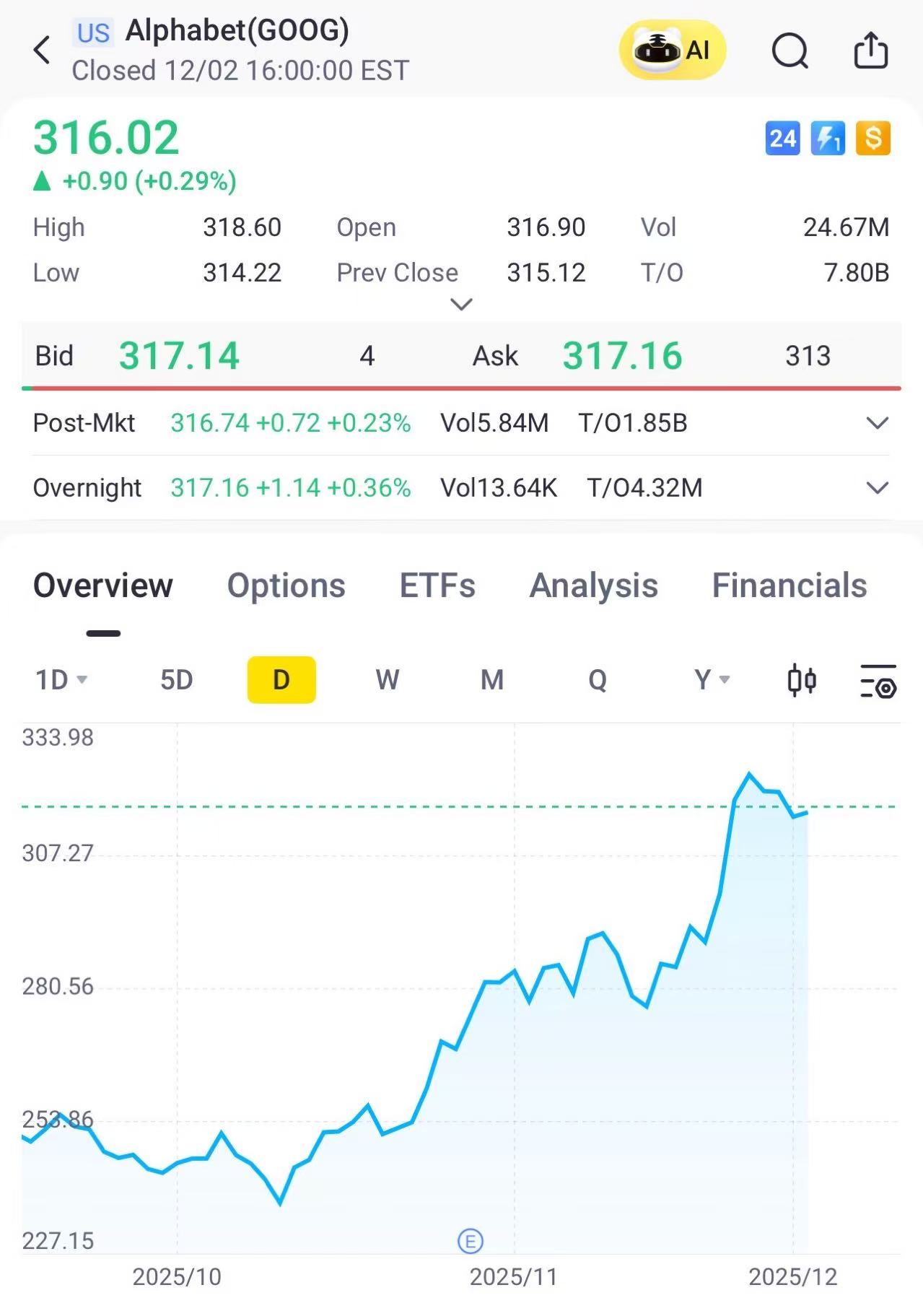

Google行情走勢

Google行情走勢

一、TPU 與 GPU 的雲端性價比:取決於生態成本與遷移代價

兩者直接對比價格並不簡單,原因在於軟件生態的遷移成本:

1、 GPU 生態完整,開發者使用 Cuda 上手最快

2、 TPU 更便宜,但前提是開發者願意爲其重寫部分代碼

3、 老練的科技巨頭如 Apple、Anthropic、Meta 對 TPU 的軟件適配難度更低

前 Google 與英偉達工程師均表示,在特定類型的大規模訓練任務下,TPU 在成本效率上可能優於 GPU;尤其是訓練 Google 自家 Gemini 時,TPU 的成本優勢尤爲明顯。

二、黃仁勳曾說“即使對手芯片不要錢也沒人會買”?事實沒那麼簡單

即便英偉達技術領先,它仍然面臨一個關鍵限制:臺積電產能不可能無限度傾斜給單一客戶。

因此市場上會有一部分 “GPU 需求缺口”,這些需求自然會尋找其他可替代芯片,例如 TPU、AWS Trainium、AMD MI300 等。也就是說,即便不是性能或價格因素,供應鏈瓶頸也會推高對競爭芯片的需求。

三、性能差距:最先進的 TPU 與最先進 GPU 相比究竟差多少?

行業人士給出的對比數據顯示:

1、 Google 最新 TPU Ironwood 的單芯片算力約爲英偉達 Blackwell 的一半(以 FLOPS 衡量)

2、 Google 可以在數據中心內部把數千顆 TPU 串聯成一個大型 Pod

3、 英偉達單連接上限是 256 顆 GPU(可用額外網絡線纜擴展)

單芯片性能上,GPU 明顯更強;但 TPU 在規模化訓練大模型時,能通過大規模 Pod 獲得效率優勢。

四、TPU 與 GPU 的架構差異:誰更適合哪類模型?

GPU 是通用計算加速器,能勝任各類機器學習與圖形渲染;TPU 更像是“爲矩陣計算而生”的專用加速器。

TPU 的 systolic array(脈動陣列)結構,使其在矩陣乘法任務上效率極高,且能減少大量訪存時間,從而降低能耗。

但缺點同樣明顯:只能在部分軟件框架下發揮優勢,例如 TensorFlow,而主流研究團隊依然以 PyTorch 爲主。

因此:

1、 訓練關鍵的矩陣密集型任務,TPU 成本更好

2、 若涉及大量自定義算子、複雜圖像增強流程,GPU 往往更靈活、更高效

對圖像、視頻模型而言,TPU 在卷積類計算上有優勢,但 GPU 適合需要頻繁試驗複雜預處理和圖像變換的研究場景。

五、誰在使用 TPU?

1、 Apple 長期用 TPU 訓練最大規模語言模型

2、 Midjourney 2023 年曾公開表示使用 TPU

3、 Meta 正在認真評估 TPU,尤其用於下一代模型訓練

4、 Cohere 曾試用 TPU,因早期版本出現問題而改用 GPU

總體來看,科技巨頭更願意接觸 TPU,而中小企業更傾向 GPU,因爲後者生態完整、開發門檻低。

六、Google 若要真正對標英偉達,需要改造整個供應鏈

若 Google 想把 TPU 大規模賣到其他企業數據中心,就必須複製英偉達的商業模式,包括:

1、 確保足夠產能

2、 佈局全球銷售渠道

3、 與服務器廠商合作做整機交付

4、 組建大量的客戶支持與軟件工程團隊

簡單說:TPU 想像 GPU 一樣賣給全球,需要的是 Google 從研發型公司變成“半導體體系公司”。

七、TPU 與 GPU 的製造成本:究竟誰更貴?

臺積電負責爲 Google 與英偉達製造芯片:

1、 TPU Ironwood 使用比 Blackwell 更先進的工藝

2、 但 TPU 面積更小,每片晶圓可切割更多芯片,因此抵消部分成本

3、 兩者均需要昂貴的高帶寬內存(HBM)

英偉達銷售 GPU 的毛利率約爲 63%,而 Google Cloud 整體毛利率只有 24% 左右,說明 Google 並未像英偉達那樣把 TPU 當成“高毛利硬件生意”去賣。

八、Google TPU 的生產規模:未來兩年要翻倍

摩根士丹利預測:

1、 2026 年生產超過 300 萬顆 TPU

2、 2027 年提升至 500 萬顆以上

3、 Google 內部甚至向部分客戶透露可能目標更高,但能否獲得臺積電產能尚不確定

目前英偉達每年的 GPU 產量約爲 Google TPU 的三倍。

九、Broadcom 在 TPU 產業鏈的角色

Broadcom 是 TPU 項目的關鍵合作伙伴,負責:

1、 芯片的物理設計與封裝

2、 與臺積電的製造協調

3、 提供高速 SerDes(串行器/解串器)知識產權,用於 TPU 間高速通信

這項合作規模至少價值 80 億美元。

十、如果 Google 將 TPU 租賃到第三方數據中心,會發生什麼?

若 TPU 部署在非 Google Cloud 的數據中心:

1、 這些數據中心必須按照 Google 的技術標準設計,否則無法獲得成本優勢

2、 Google 可能會在售價中加入額外溢價,以彌補失去的雲服務收入(例如存儲、數據庫等)

這也是 Google 遲遲不願開放 TPU 的原因之一:對它來說,TPU 更像是拉動 Google Cloud 的 “綁定武器”。

十一、Google 爲什麼執意開放 TPU?

核心原因包括:

1、 金融、科技企業希望在自己的數據中心內部署 TPU(非 Google Cloud)

2、 Google 已向多家雲廠商提議合作代管 TPU

3、 即便客戶最終不用 TPU,也能借此壓價英偉達

4、 TPU 更普及有助推廣 Gemini 模型,因爲 Gemini 原生針對 TPU 優化

更深層的原因是:英偉達生態過於強大,Google 必須擴大 TPU 的使用場景才能讓自家模型保持競爭力。

十二、PyTorch XLA、JAX 等新工具是否縮小了 TPU 與 GPU 的軟件鴻溝?

結論是不明顯,至少在短期內如此。

Google 正努力推動 TPU 的軟件易用性,但與 Cuda 上百萬人規模的開發者生態相比,差距仍然巨大。

TPU 想真正走向通用化,還需要幾年時間。